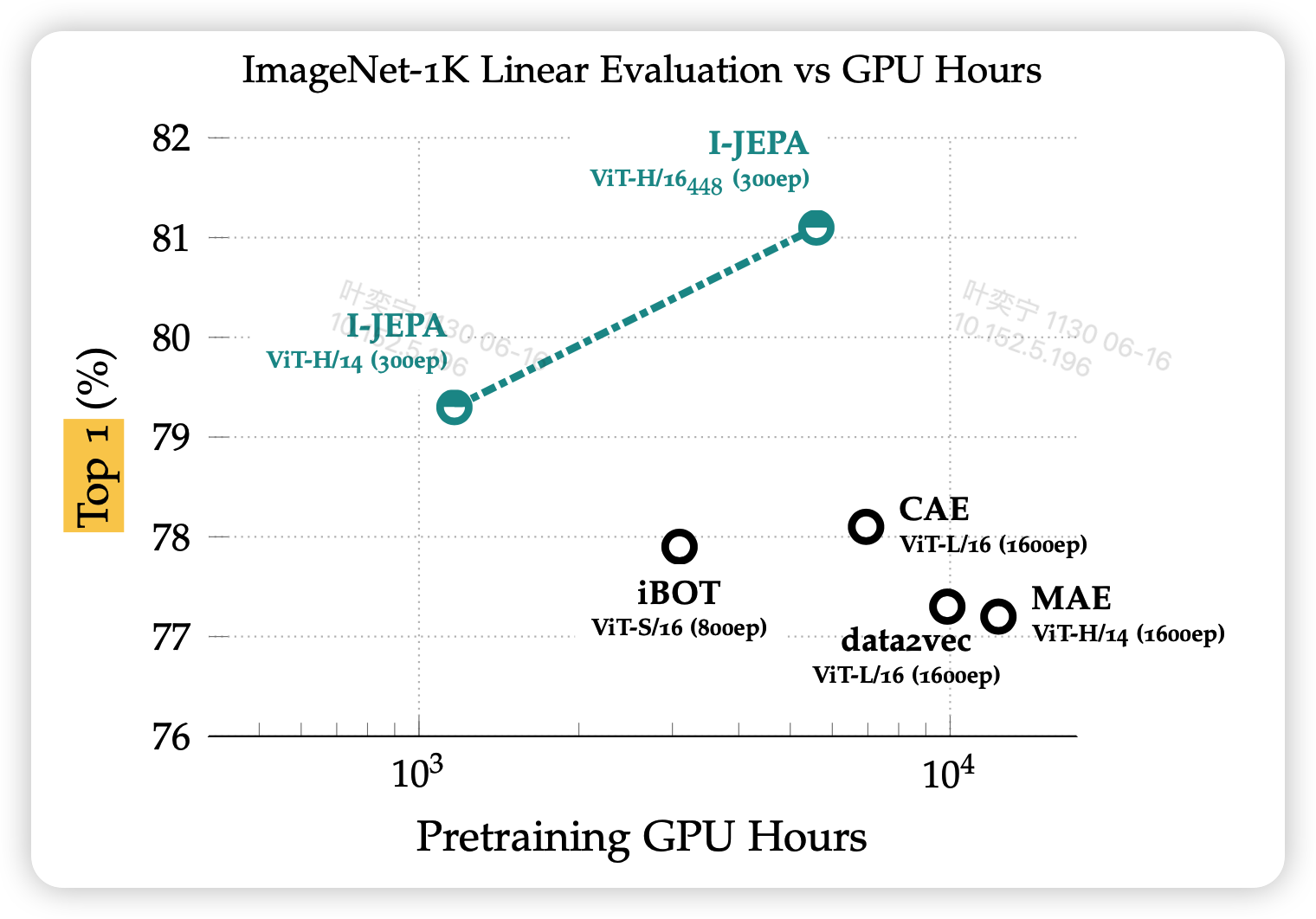

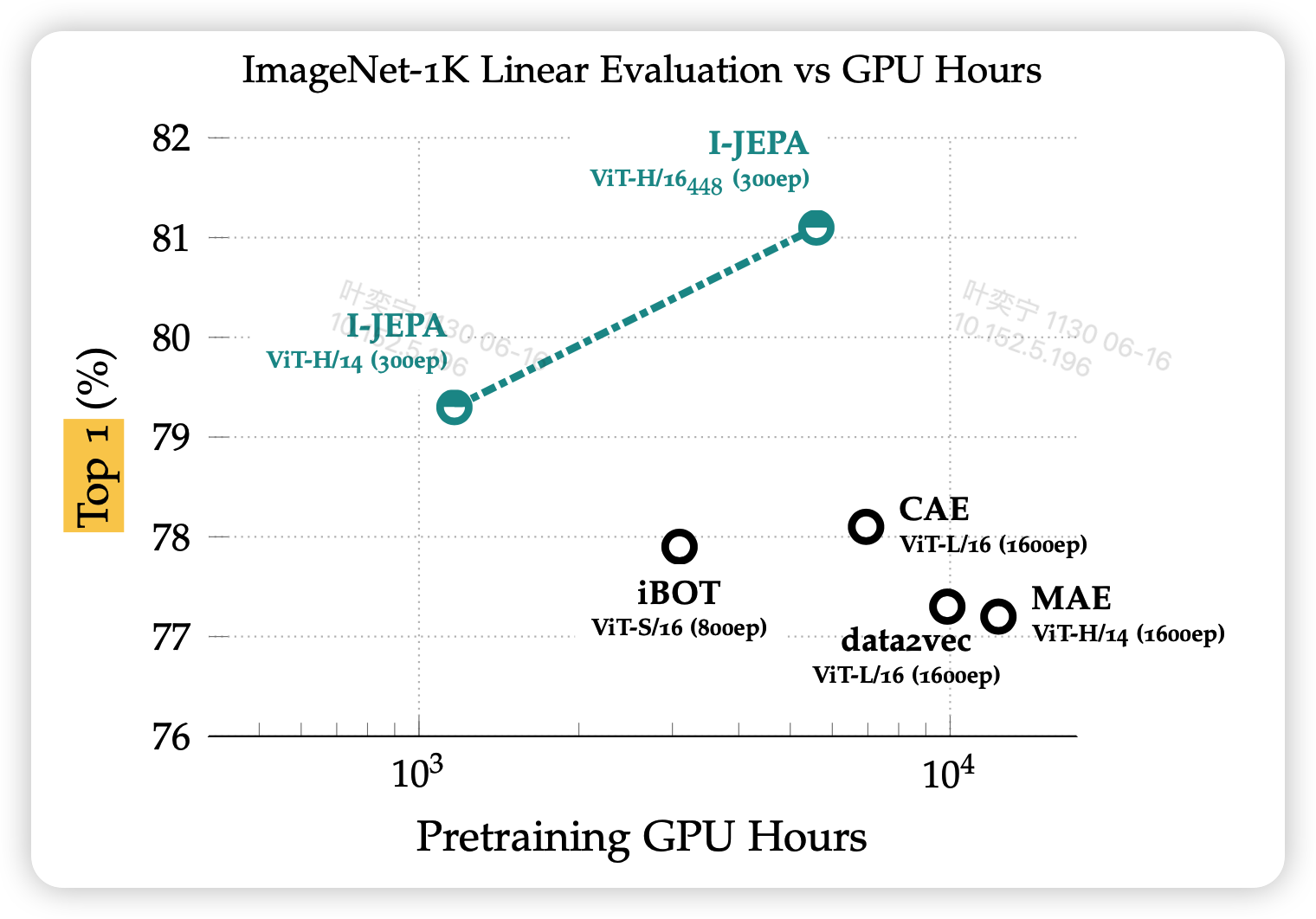

好长时间没写论文阅读笔记了,今天读一下LeCun讲了一年的"世界模型":新的训练范式、训练快、参数少(0.6B)、效果好、方法简单、概念明确。

我在讲解时会说一些我的思路,因此我里面提到的一些优点、缺点有一些不是论文里说的是我自己的观点,完整故事逻辑大家可以去看原论文,论文写得很好。

好长时间没写论文阅读笔记了,今天读一下LeCun讲了一年的"世界模型":新的训练范式、训练快、参数少(0.6B)、效果好、方法简单、概念明确。

我在讲解时会说一些我的思路,因此我里面提到的一些优点、缺点有一些不是论文里说的是我自己的观点,完整故事逻辑大家可以去看原论文,论文写得很好。

好久没写随笔了,今天一写突然发现好像博客快要更新一年了。这下子随笔的标题得把年份加上,和往年的时间加以区别了。笑死,让我想起了"千年虫"事件。这下我的博客要发生”一年虫“危机了。

千年虫:曾经的计算机使用2位十进制数计年,所以到了横跨世纪的时候就会报错

之前看了阿西莫夫的小说《最后的问题》,里面讲到了宇宙里最令人绝望的定律”熵增定律“。今天讲讲人工智能领域最让人绝望的规律”emergent abilities“,在结合最优传输说说我对这个现象的理解,最后聊几个有趣的话题。参考:

Emergent Abilities of Large Language Models

Can LLMs Critique and Iterate on Their Own Outputs?

压缩下一个token通向超过人类的智能

今天讲讲强化学习里的经典算法PPO,也是现在Gym库里默认的强化学习算法,最后再讲讲RLHF中的PPO算法是怎么算的。参考

Proximal Policy Optimization Algorithms

Trust Region Policy Optimization

A (Long) peek into Reinforcement Learning

转眼又是一周过去了,时间过得越来越快了。今天被同学提醒:开学已经第四周了,感觉好像才开学一样。

今天openAI发布了GPT-4。直接把PaLM卷到开放API了,相信google是真的被卷麻了。

GPT4附赠了一个98页的报告(没有论文),报告前面是性能和应用报告,中间是一些附录,最后是技术报告。我就按顺序来给大家讲讲,先讲应用报告。相信很多公众号大概都吹了一波GPT4,我希望我的讲解可以更深入一些,把问题、难点和领域更多地呈现给大家。