最近ICLR快截稿了,各种iclr风格的论文都来了,很多内容还挺好玩的

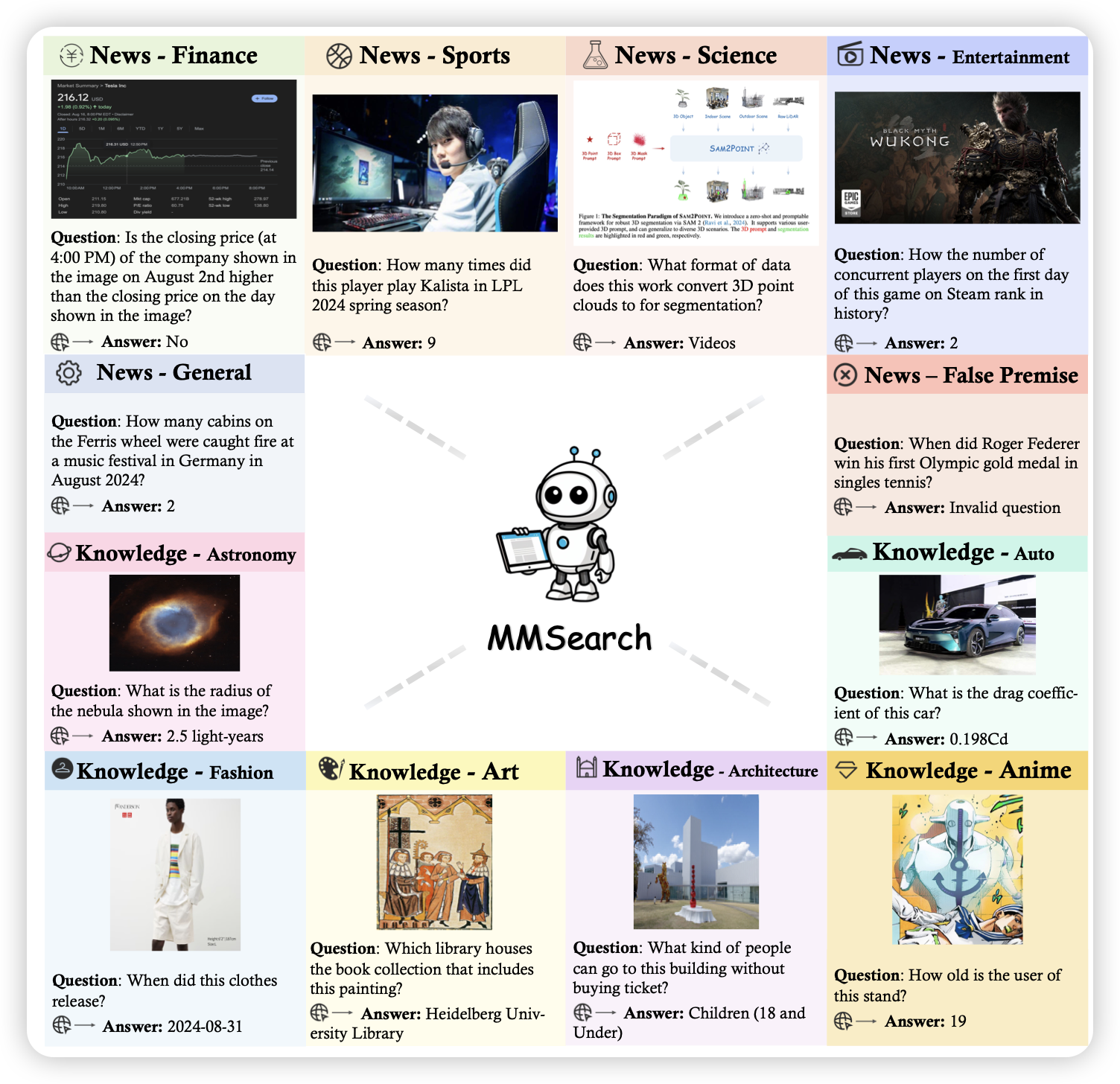

MMSearch: Benchmarking the Potential of Large Models as Multi-modal Search Engines

作者设计了一个benchmark,来测试不同模型作为搜索引擎的效果。发现4o效果最好,超过perplexity

你说得对,但jackeylove真会卡莉斯塔吗?

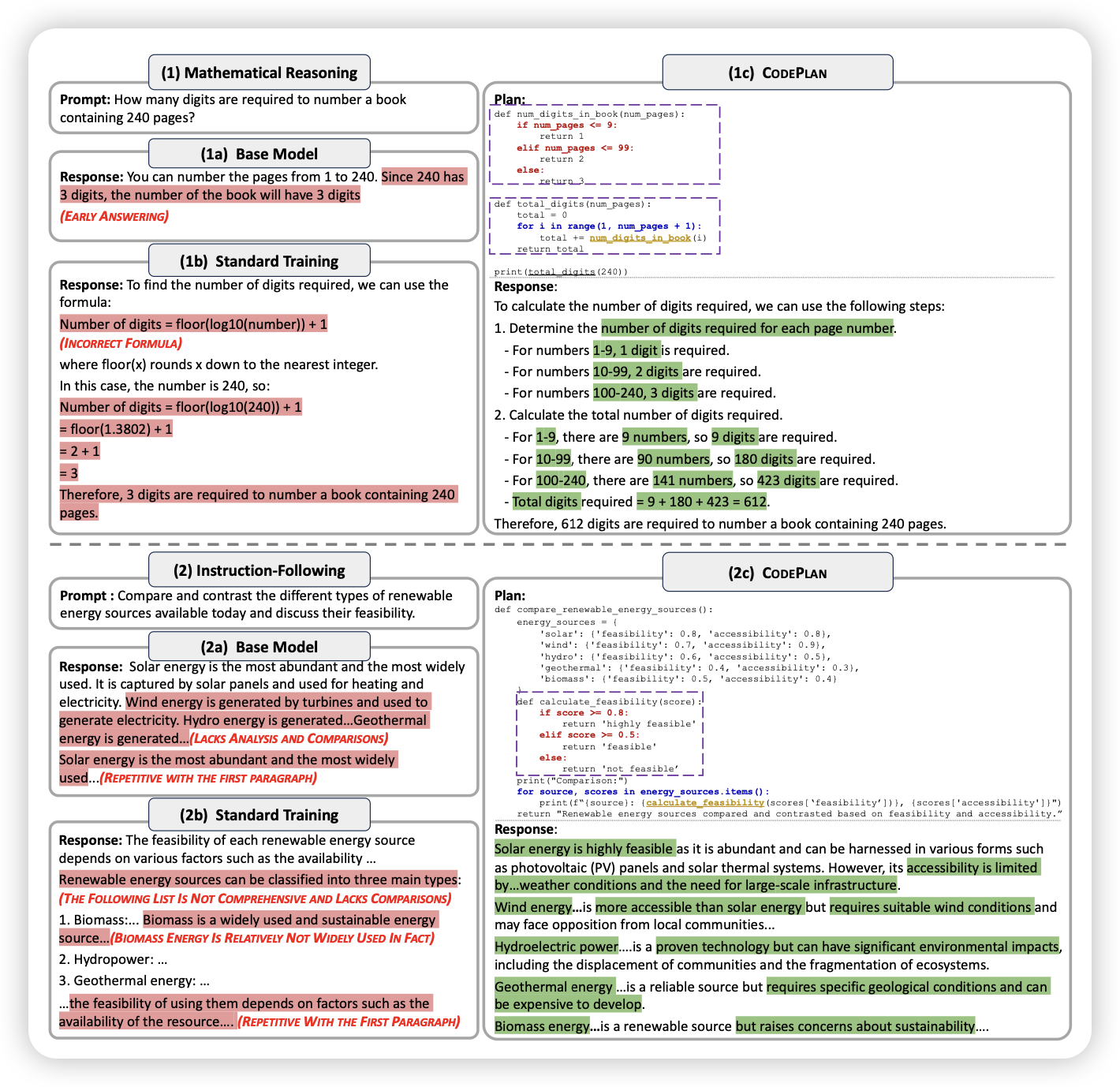

CODEPLAN: UNLOCKING REASONING POTENTIAL IN LARGE LANGUAGE MODELS BY SCALING CODE-FORM PLANNING

黄民烈老师的工作,大图致敬ReAct的论文图:作者觉得模型代码能力很强,能不能用代码语言做planning呢?找到了一种方案从预训练语料里自动抽取这种code类型的planning。

想起来前几天Scale AI那个 planning in NL。这两拨人是不是得先打一架……

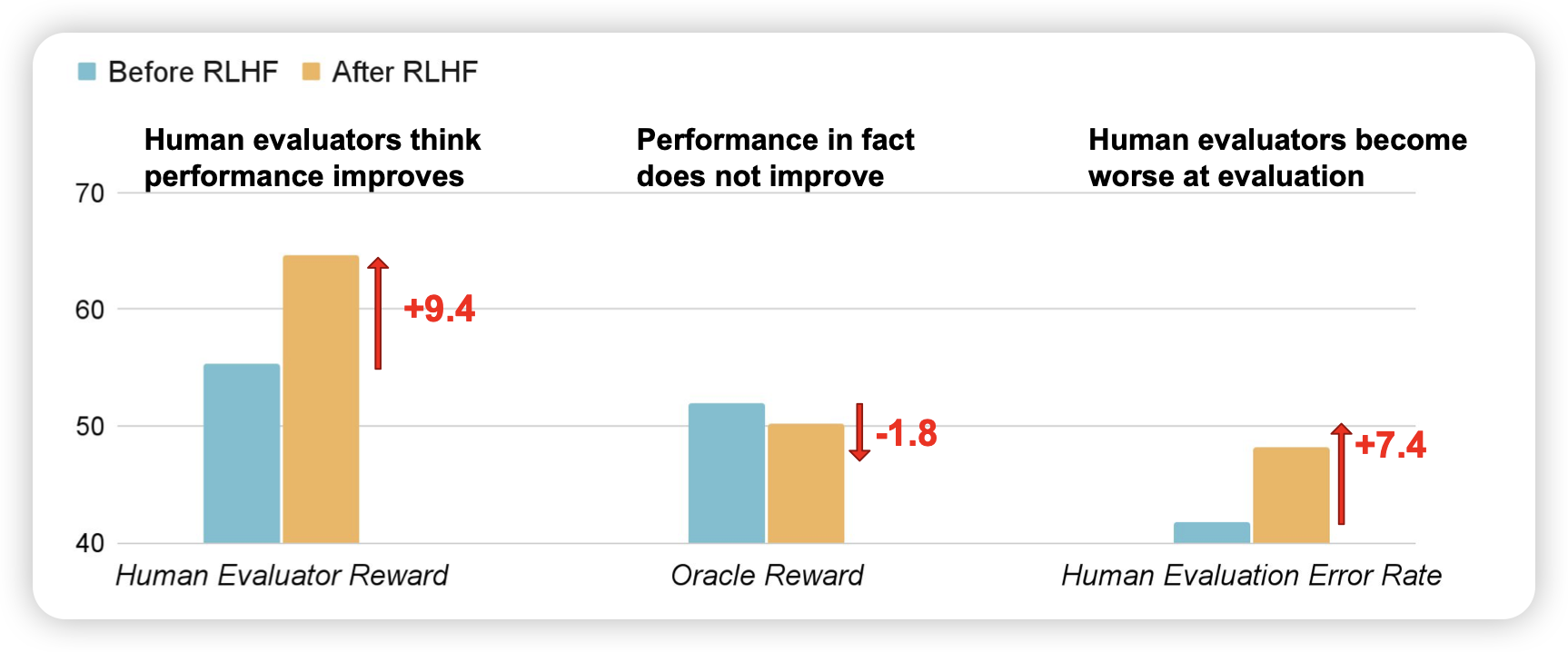

LANGUAGE MODELS LEARN TO MISLEAD HUMANS VIA RLHF

作者发现了一个好玩的现象:在rlhf以后的模型,学会了怎么样说服人类,即使本身的准确率没有提升,但人类更难发现模型输出中的错误了。

所以:在模型的智力超越人类之前,可能说服力会先超越人类?