Densing Law of LLMs

首推刘导的position

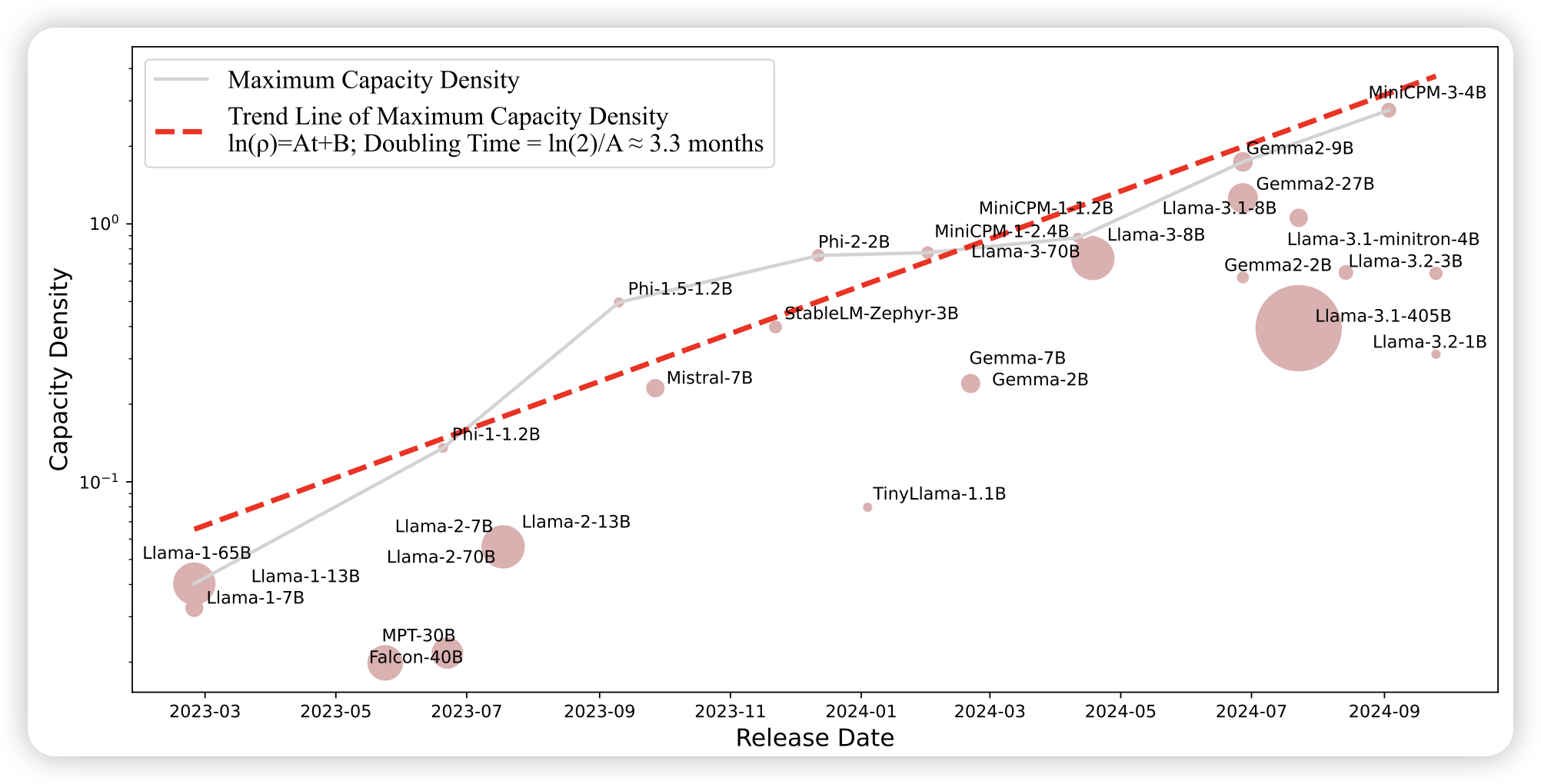

paper,已经宣传一段时间了。摩尔定律认为,每过18个月,芯片的晶体管数就翻一番,代表着人类的算力随着时间指数发展。实际上,观察相同大小(参数量)的模型,会发现比如都是7B

model,其能力也随着时间变得越来越强。具体分析,每过100天,新模型的能力就和之前2倍参数量模型的性能差不多。所以,如果把

capability/parameters定义为一个知识密度指标。模型的知识密度实际上每过100天就翻倍。

这个定律和摩尔定律是相辅相成的:人类能训出越来越大的模型,同时相同大小模型的能力也在提升。一个是算力,一个是算力效率。如果花3个月才能训出来一个400B模型,讲道理就算是白训了……因为数据版本落后一个dense law区间了

感觉知识密度随时间的曲线在 o1-based model开始出现以后,又会有一个薄发。

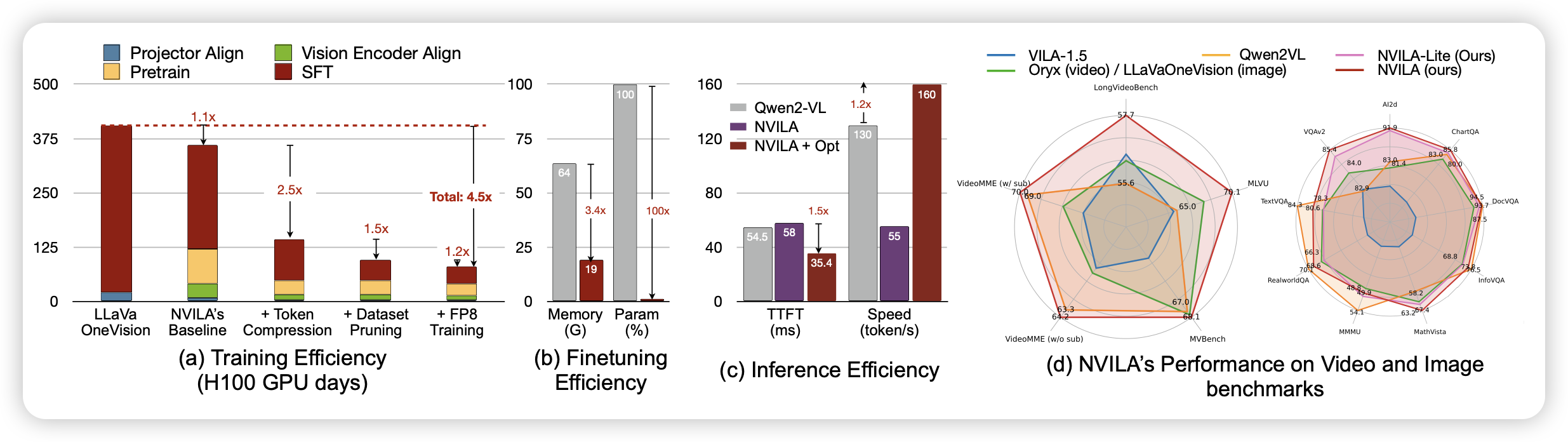

NVILA: Efficient Frontier Visual Language Models

nvidia新出的VLM family,最近感觉nvidia research做得有点风生水起的感觉,是不是来openAI情报了。

HunyuanVideo: A Systematic Framework For Large Video Generative Models

tecent的video generation model总算出了,感觉video generation这个领域从学界巨头卷,逐渐演变成公司卷了。主要是私有数据的构造速度和质量确实差太多了……