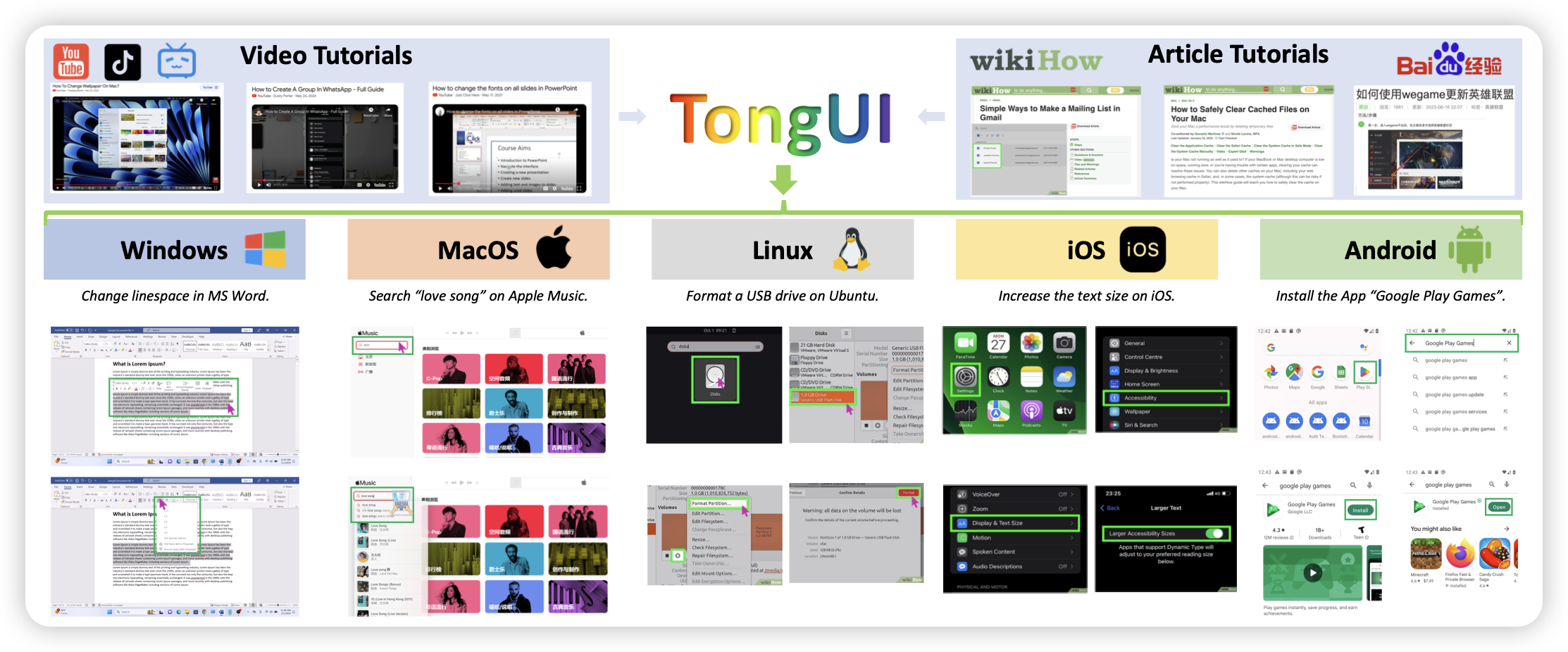

TongUI: Building Generalized GUI Agents by Learning from Multimodal Web Tutorials

这篇工作中,作者强调了gui教程数据的重要性,作者把wikihow等几个数据源的数据转换成了多步执行的形式,然后训进模型,发现涨分了。

开源数据,推荐!

PerceptionLM: Open-Access Data and Models for Detailed Visual Understanding

meta就是有钱,找人标了2.8M个video qa和caption,还开源了

开源,我直接推荐!

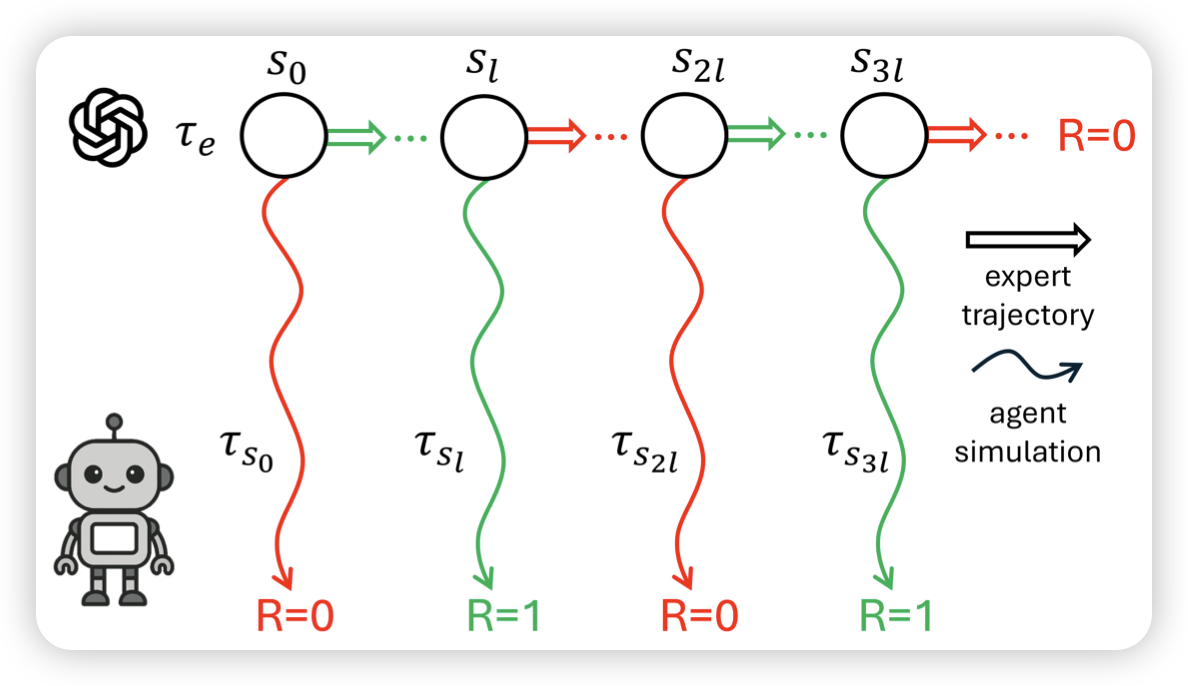

Exploring Expert Failures Improves LLM Agent Tuning

这篇工作的思路很精彩。作者发现目前的sft数据里,往往训练成功的trace,但是这些任务更可能是简单的。作者认为,失败的trace里反而更可能蕴含一些信息价值极高的step。能不能找到一种方案把这些step挑出来,然后也训进去呢?作者发现还真可以

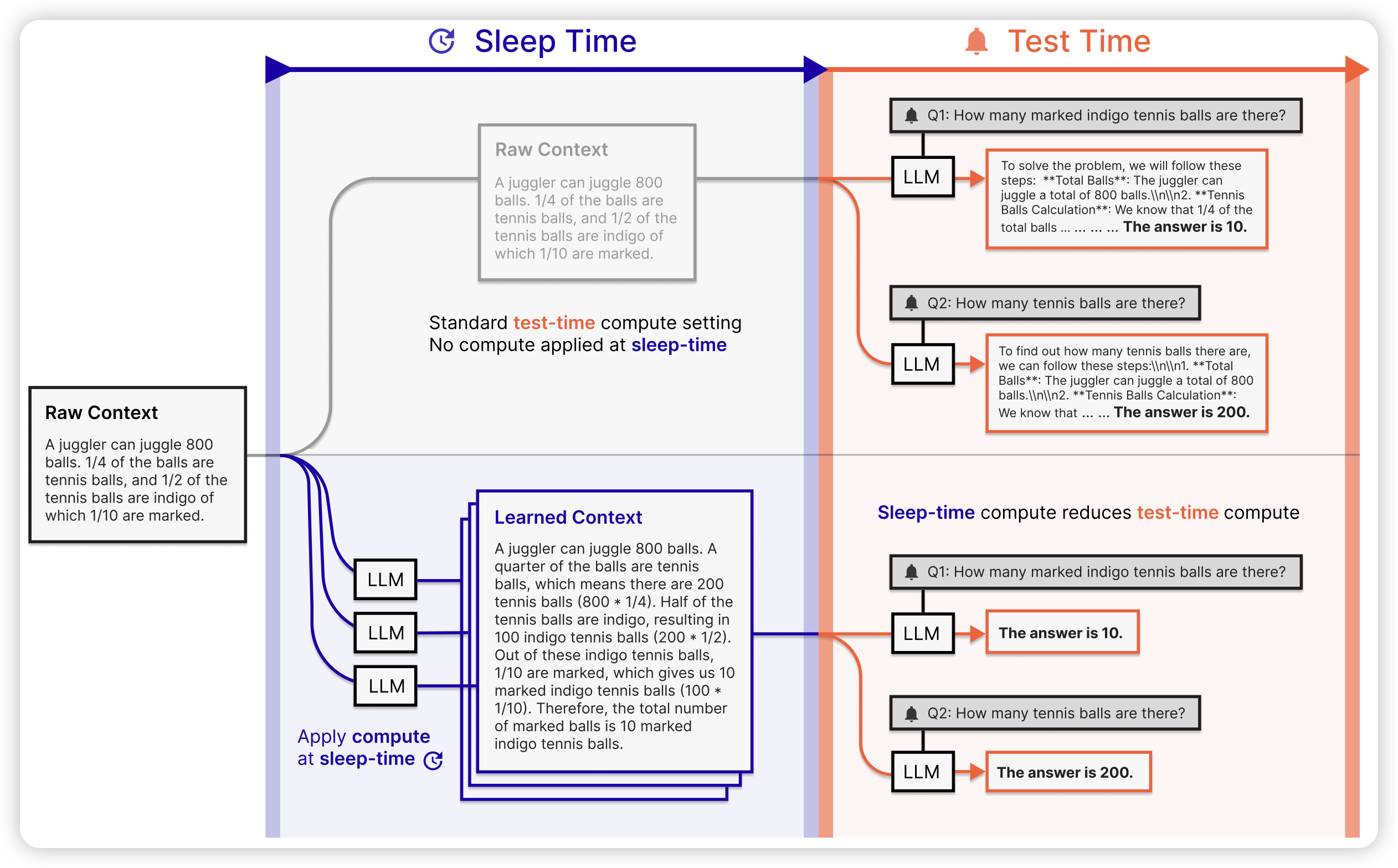

Sleep-time Compute: Beyond Inference Scaling at Test-time

这篇工作做得场景比较简单,但是思想很深刻:作者发现目前的o1 model,都是给出一个query以后,生成一大堆思考问题;但是,reason需要的信息却不一定要和query相关。如果模型可以基于一些无query的语料做预先思考,等真的遇到问题是否就可以用更短的思考时间了呢?作者发现还真可以,并且在构造的domain上可以省5倍

我有个直觉,这个方法可能可以把o1做到预训练里去