最近换了AI track和CV track才发现:有这么多人在研究diffusion model啊……感觉比研究LLM的人还多。还有研究stock prediction的 [doge]

Improving Multimodal Large Language Models Using Continual Learning

这是一篇研究VLM中的灾难性遗忘的工作,作者在pythia 2.8B中尝试了不同的方案,看看能否在llava中恢复LLM的能力。

目前看到的工作好像都是通过掺一些text-only数据去缓解这个问题。话说我有个更high level的问题:随着模型参数量增大(或者预训练token量变大),有没有可能灾难性遗忘这个问题会自然消失呢?只要记忆力够(或者印象够深刻),就不会忘东西了?

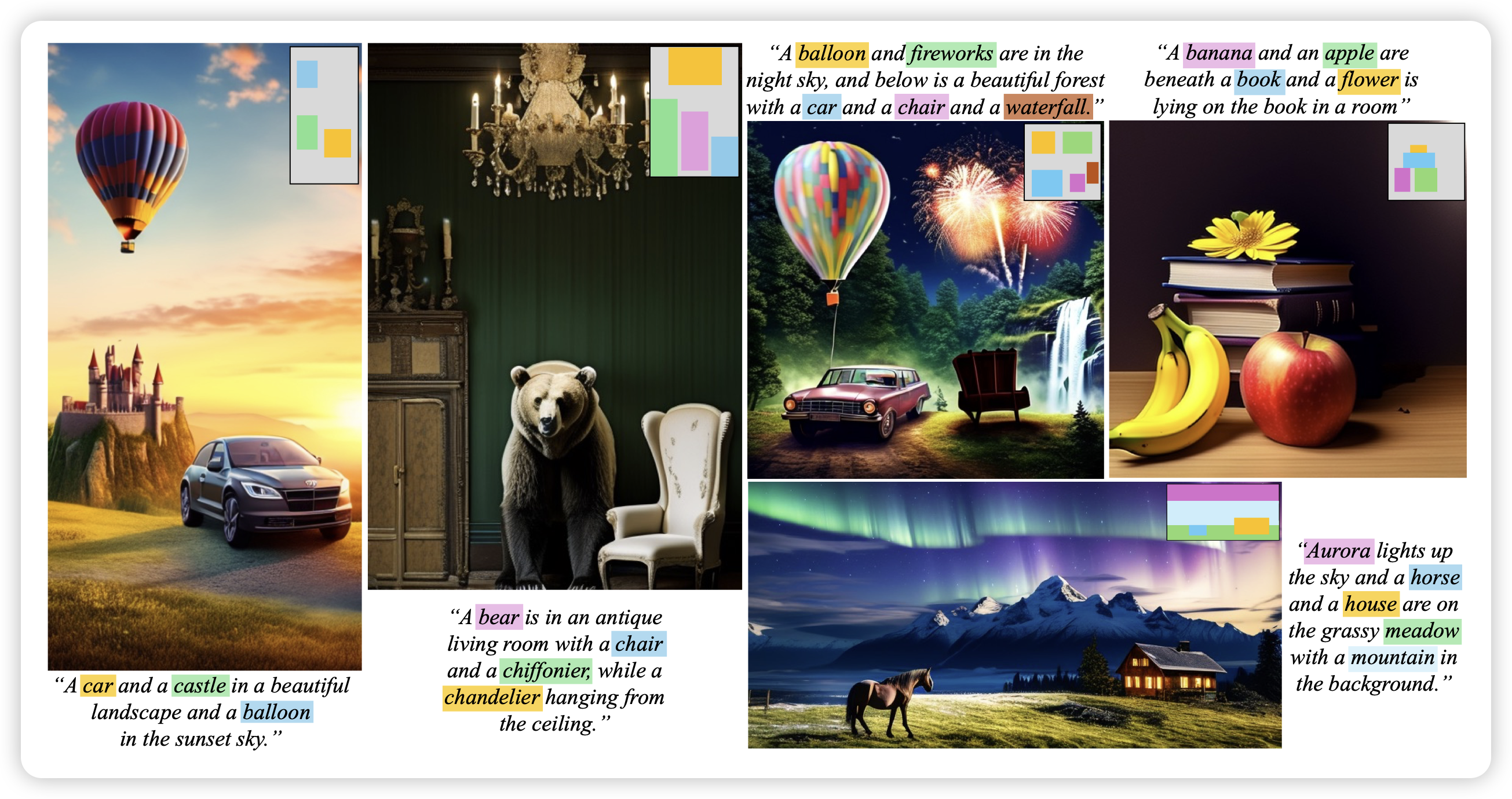

GrounDiT: Grounding Diffusion Transformers via Noisy Patch Transplantation

作者搞了一个新的任务:如果输入的text不只是text,而是对于其中的某些名词,额外指定了在图片中的位置,模型能不能正确生成呢?作者发现还真可以。

感觉现在的text2image在发掘VLM任务里面的对偶任务:像这个任务,其实是VLM里面的REG任务,把text中的名词对应到图片中的指定位置。

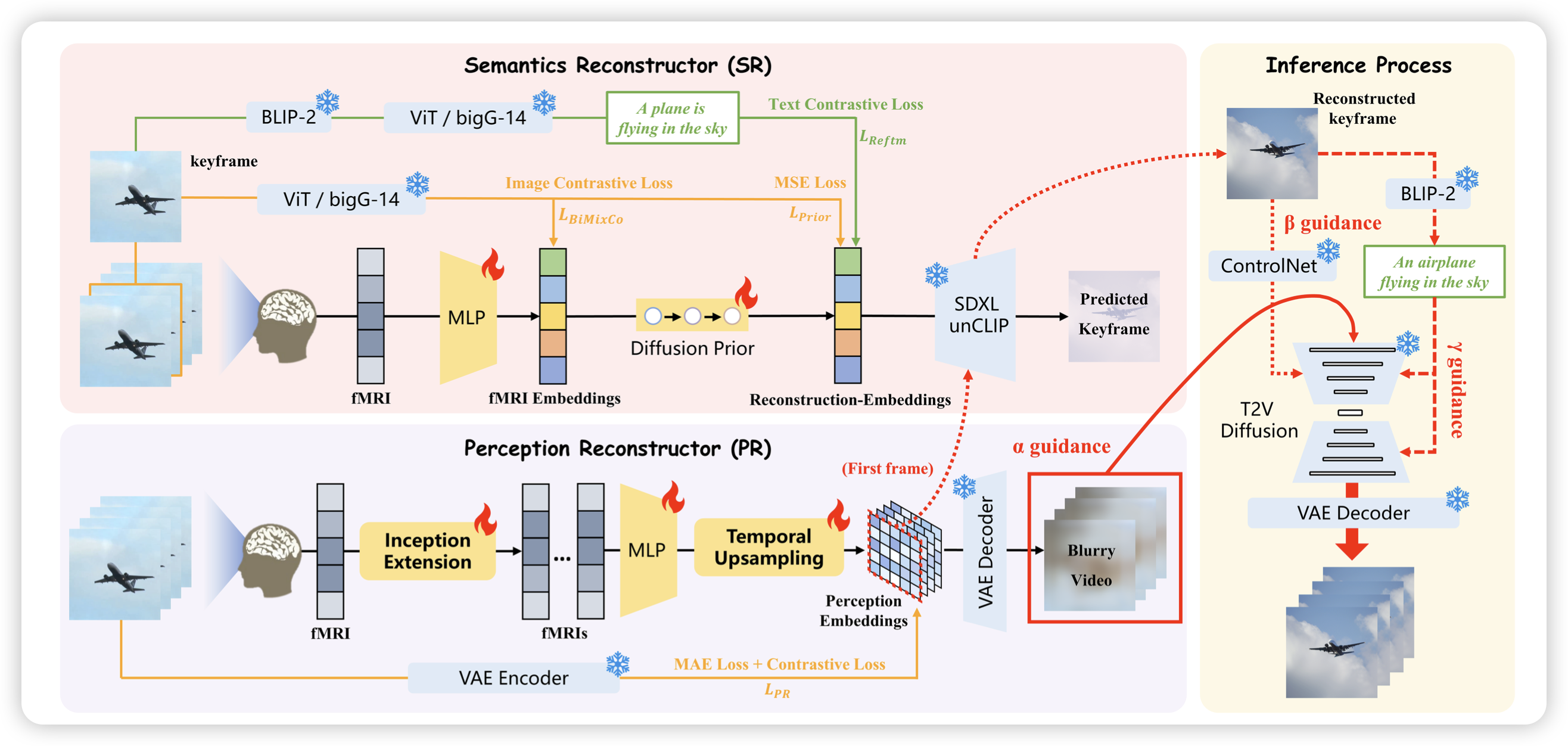

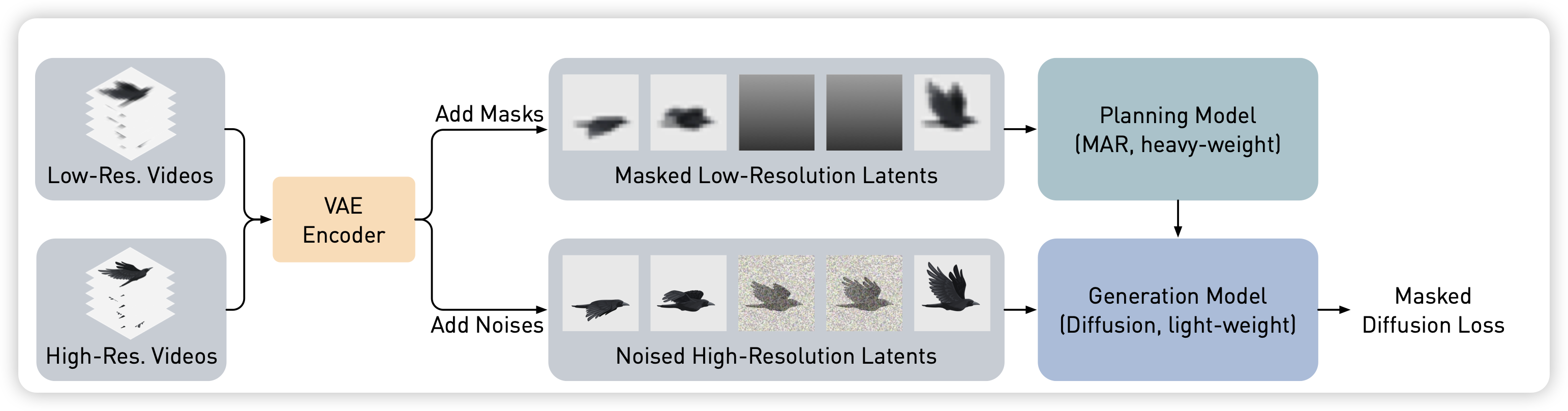

MarDini: Masked Autoregressive Diffusion for Video Generation at Scale

Meta的工作,作者设计了一个巧妙的方案,拆分了视频生成中的空间信息和时间信息两个维度。具体来说,作者把同一个视频搞出来了低清晰度和高清晰度两个版本,在低清版本中实现时序的consistency,在高清版本中实现空间的consistency,最终用端到端的diffusion loss对视频生成做建模

聪明!

GPT-4o System Card

OpenAI出手,必须推荐。虽然但是,没讲技术方法,讲了所有的安全性测试和对齐方面的探索