今天第一次尝试将Arxiv最新论文同步到博客。

扫描Arxiv的工作现在基本每天都做,最开始可能还要追溯到两年多前。曾经用过各种各样的方式完成这件事:

- 最开始是超哥带着大家每天扫描,每人按日期做分工

- 后面一段时间我自己每天刷一刷

- 后来形成习惯了,要写一个飞书文档同步进去,后来觉得太麻烦,最后就不了了之了

从今天开始,试着每天把新扫描到的有趣的论文更新到博客,看看大家的反应如何。可能一个良性的循环是:一方面有人反馈我有遗漏,或者推荐哪篇论文,我就可以仔细看看,或者写一些阅读笔记。

今天第一次尝试将Arxiv最新论文同步到博客。

扫描Arxiv的工作现在基本每天都做,最开始可能还要追溯到两年多前。曾经用过各种各样的方式完成这件事:

从今天开始,试着每天把新扫描到的有趣的论文更新到博客,看看大家的反应如何。可能一个良性的循环是:一方面有人反馈我有遗漏,或者推荐哪篇论文,我就可以仔细看看,或者写一些阅读笔记。

本来想写 Self-Consuming Generative Models Go MAD , 结果突然发现被苏老师抢发了,那就换一篇。

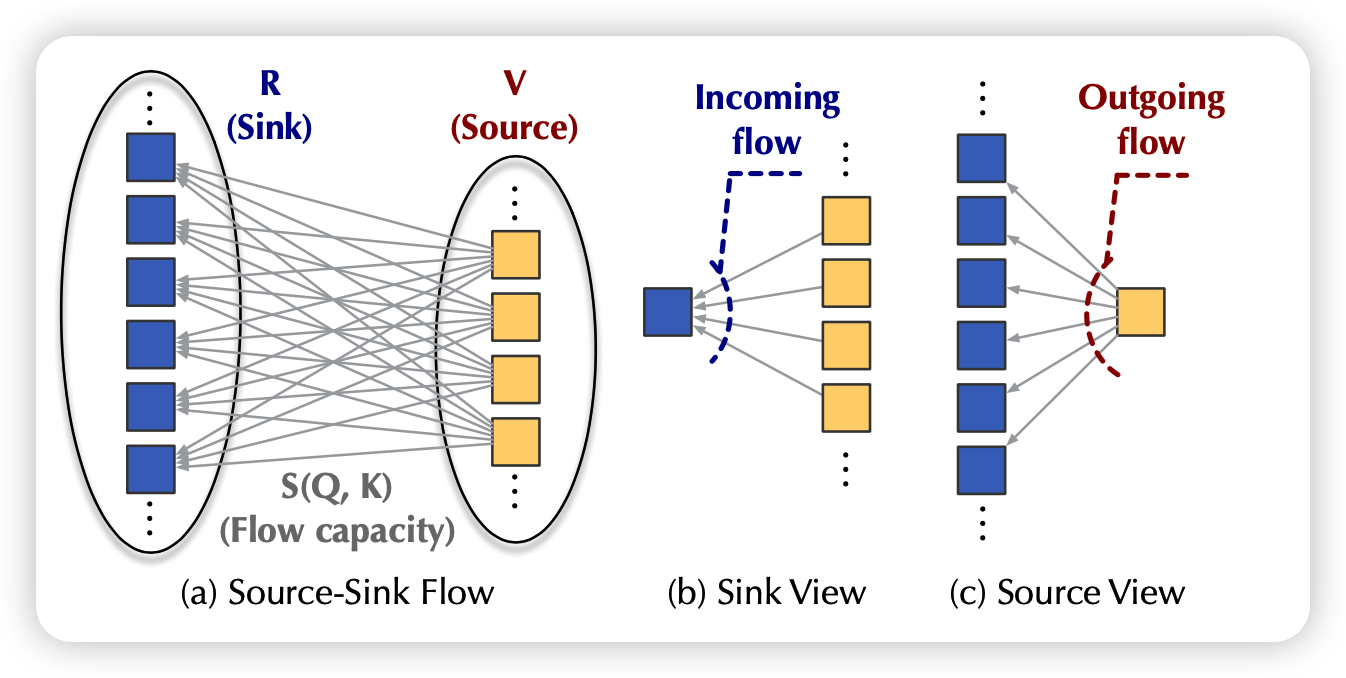

来讲讲软院去年ICML的Flowformer:如果把流图的思想引入到Attention算子中来。

这篇游神在知乎讲过一遍,我来主要分享一下在设计结构时我觉得比较好的一些思想,以及我对于线性attention的一些看法。

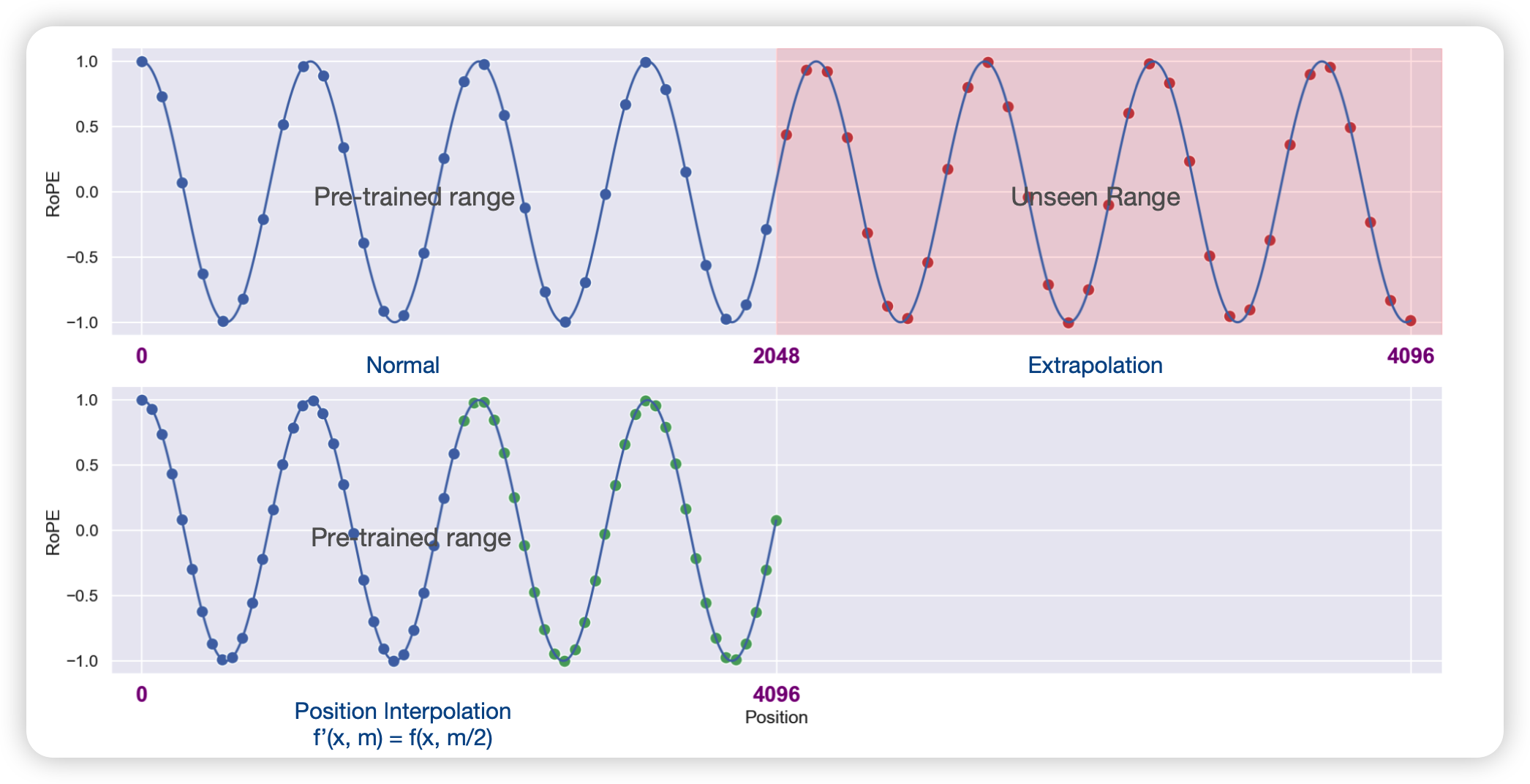

如何仅用1000步训练(0.01%资源)就将一个在2k context长度上训练的预训练模型的上下文窗口拓展到32k

我其实不想讲这篇,因为我觉得苏剑林老师肯定会讲,并且讲的比我好,但是感觉这个方法还是很有研究价值的,因此分享给大家……