今天去考驾照了,只能说,过了

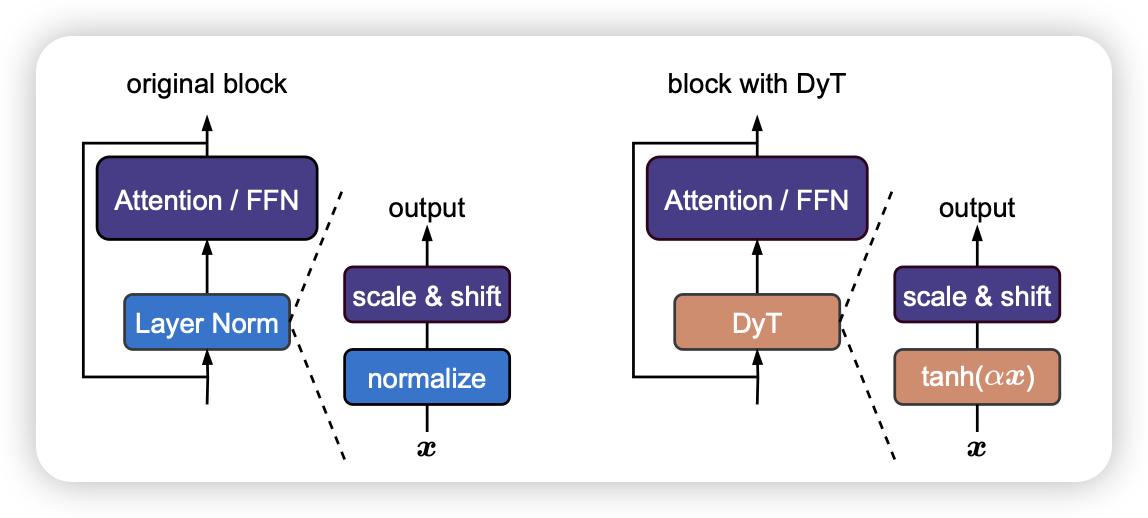

Transformers without Normalization

不是,科研也搞全明星?Jiachen Zhu, Xinlei Chen, Kaiming He, Yann LeCun, Zhuang Liu 谁来都得愣几秒。作者发现,normalization这个设计,从transformer 2017开始,一直就没换过(凡是想换的人,loss必爆nan)。作者这次还真找了办法换掉了,而且效果竟然不掉。

这个东西的意义很大,因为normalization这个算子其实很慢、尤其backward的时候。这下大家又找到加速方案了……下次谁把FFN换成快速算子?

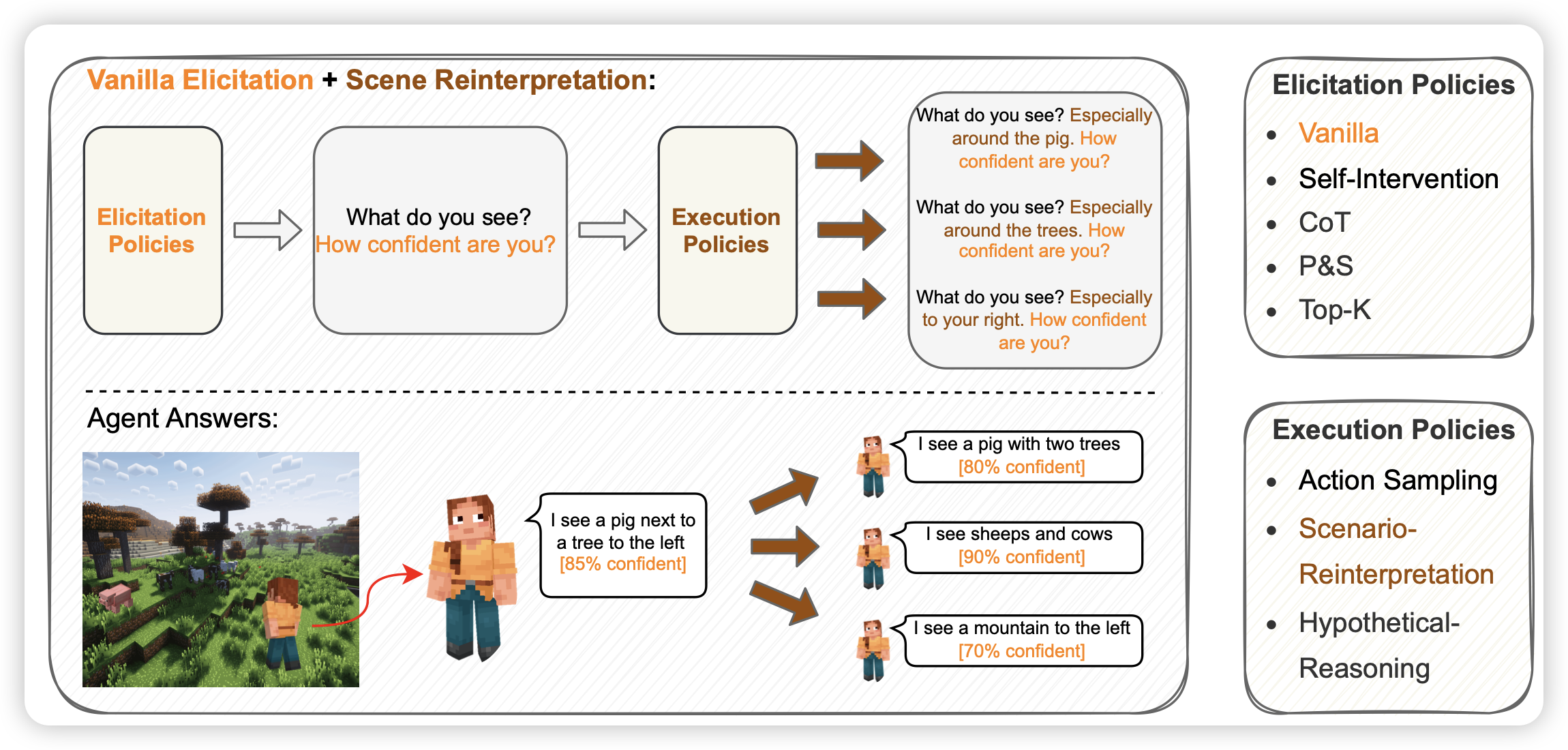

Uncertainty in Action: Confidence Elicitation in Embodied Agents

这篇文章读起来可能有点费解,但我还挺喜欢的。如果大家看过openai之前的那个Teaching models to express their uncertainty in words,这篇文章就是它对偶的agent 版本。作者探索了能否让agent在执行任务中表达自己的不确定性。

这好像是我第一次看到agent领域的calibration文章。不过我一直认为,agent领域的policy和rm就应该是一个过程

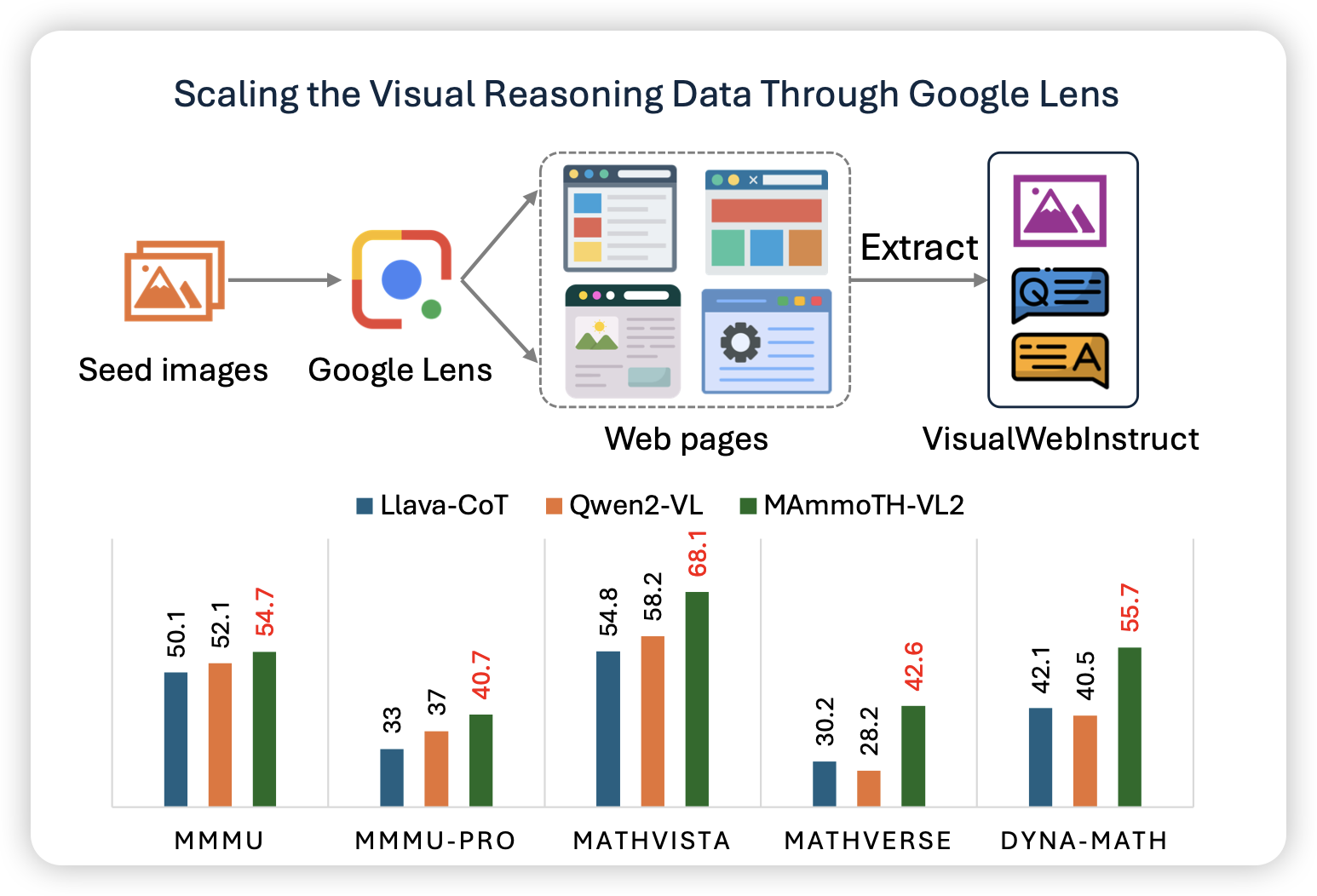

VisualWebInstruct: Scaling up Multimodal Instruction Data through Web Search

Wenhu老师的工作,乍一看还以为是deep research训练数据,原来是靠websearch构造sft训练数据。不过作者的流程也挺好玩的,作者主要解决的是VLM sft数据里缺少图片信息的问题。怎么解呢?作者发现,可以用google搜索这个图片相关的网页。这样的话,只要有一大堆图片,就能搜索到一大堆网页,然后对着网页出题了。

话说这样的话,另一个baseline是对image做caption,然后对着caption出题。如果websearch的效果更好,说明目前的caption的diversity其实是瓶颈了?