这两篇挂出来了很多AAAI的文章

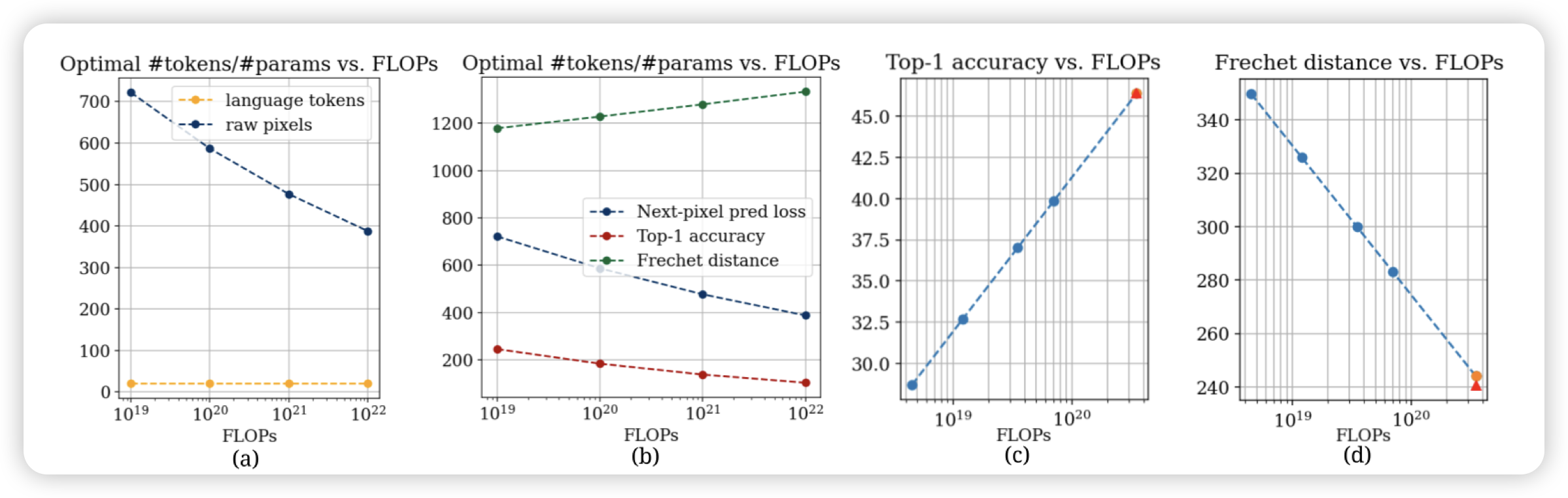

Rethinking generative image pretraining: How far are we from scaling up next-pixel prediction?

一篇next-token prediction image-generation领域的scaling law工作。大家都知道ntp的图片生成很拉,但原因在哪?

作者在各种模型参数量、训练数据量、训练flops上开展的了实验,发现了一个反直觉的结论:现在模型效果不好,并不是因为训练数据量不够,而是因为模型参数量不够大。想要做ntp的图片生成,应该扩展模型参数量

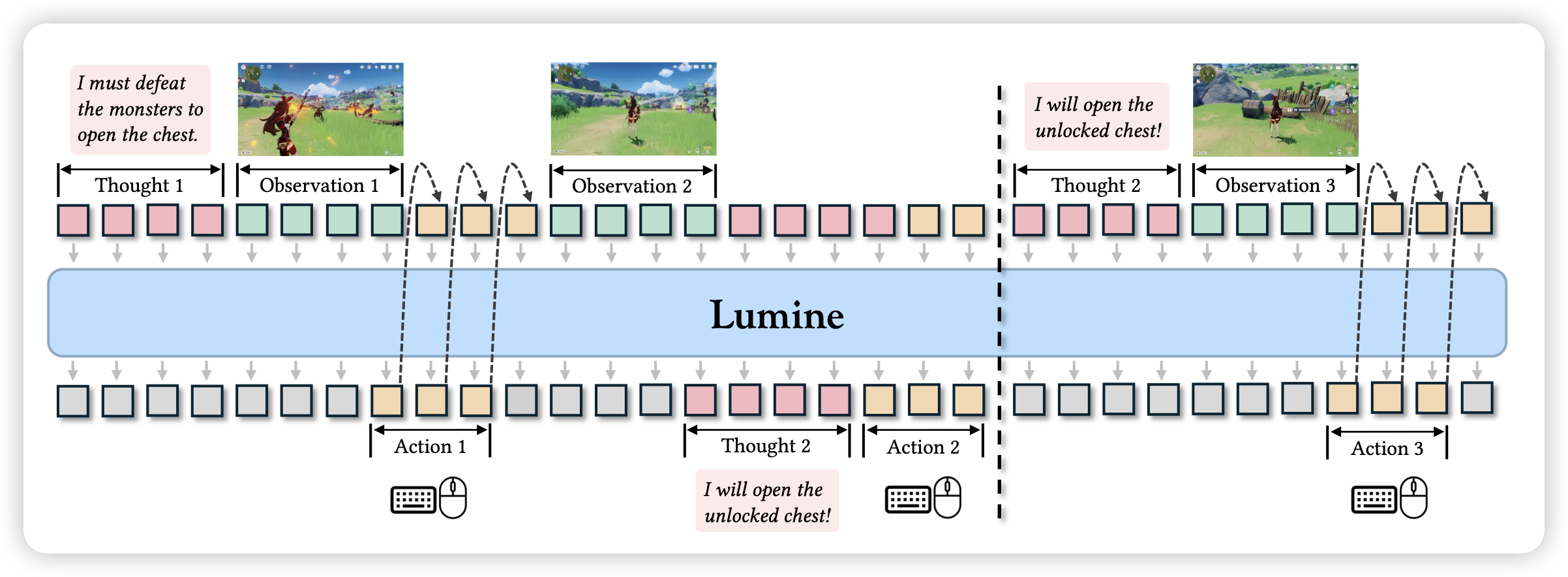

Lumine: An Open Recipe for Building Generalist Agents in 3D Open Worlds

隔壁组的工作。之前我们做了一个比较偏Minecraft的工作,这次这篇更专精原神。使用raw action space,让game model通过数据驱动的模式理解原神游戏。并且通过adaptive think的模式进行操作,也就是说:不再有react类的回合制概念,模型自己在遇到困难时才思考