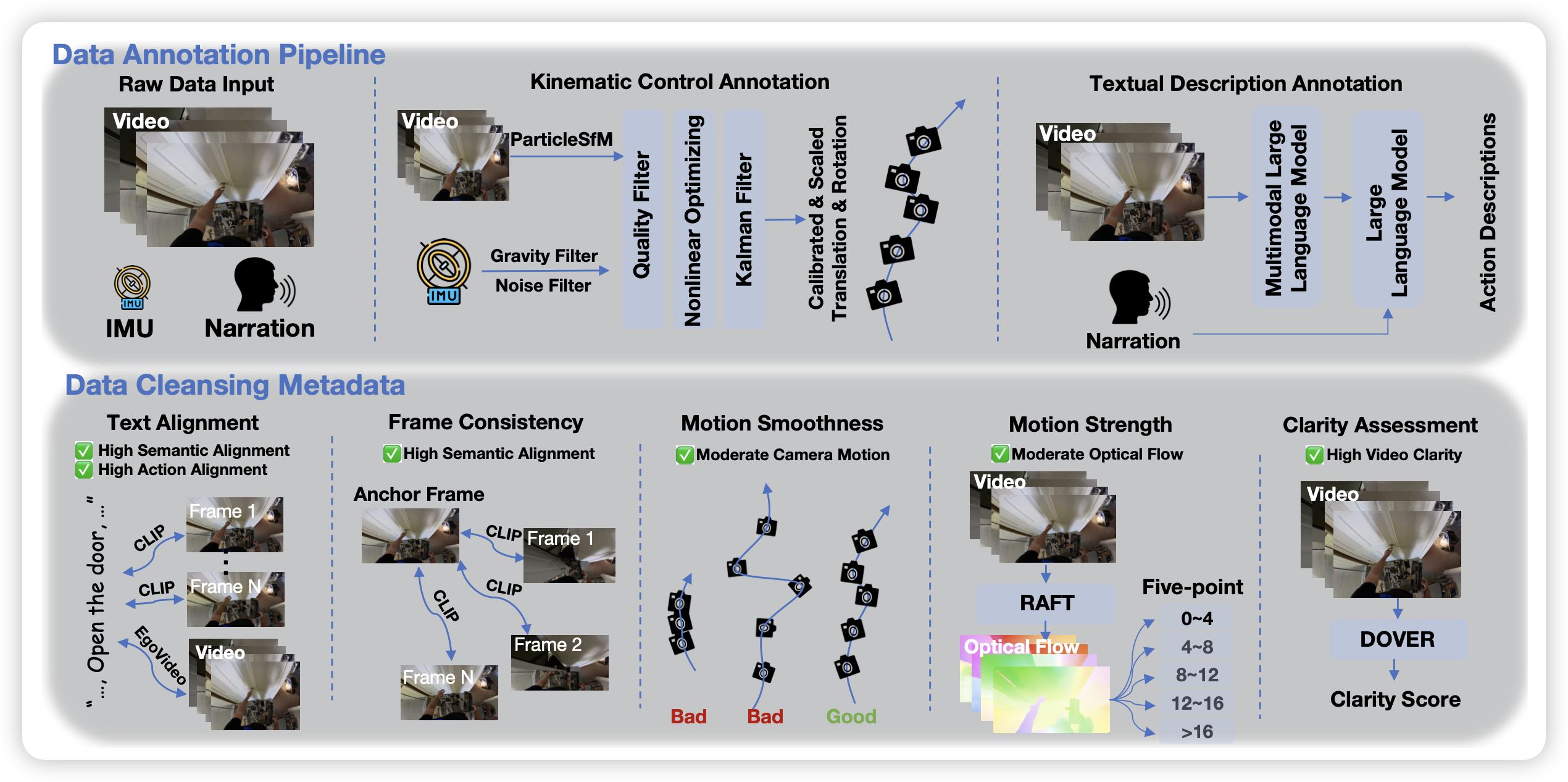

EgoVid-5M: A Large-Scale Video-Action Dataset for Egocentric Video Generation

ego video,指的是第一人称视角。作者认为,目前的视频生成领域中,一直做第一人称视角生成的不好,是因为数据不够好,作者搞了一个5M的数据集,都用LLM标注了对应的action

开源就是好

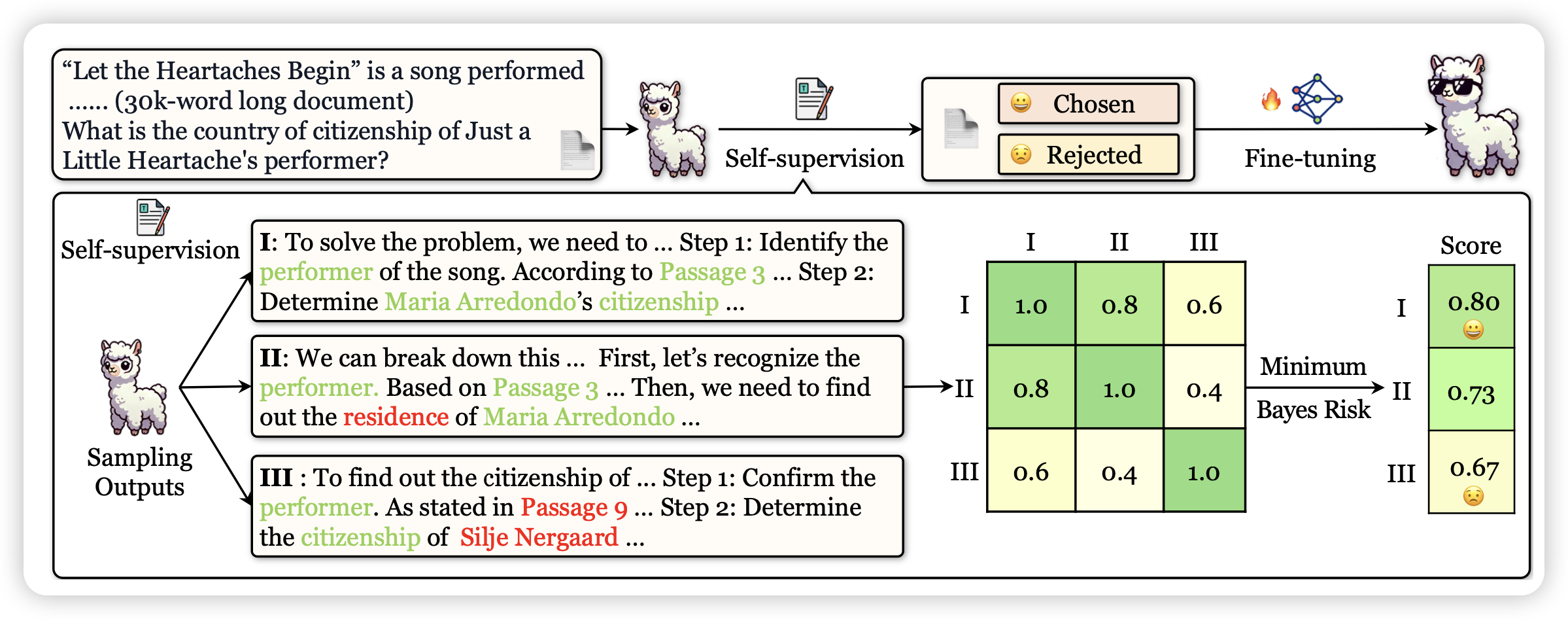

Large Language Models Can Self-Improve in Long-context Reasoning

之前neubig有个工作,通过MBR decoding在一堆trace里选一个最好的,这次有人在long-context qa里应用了一遍,发现还真能涨点。

话说STAR这块,似乎大家现在研究不是很多的样子……都去搞o1了吗