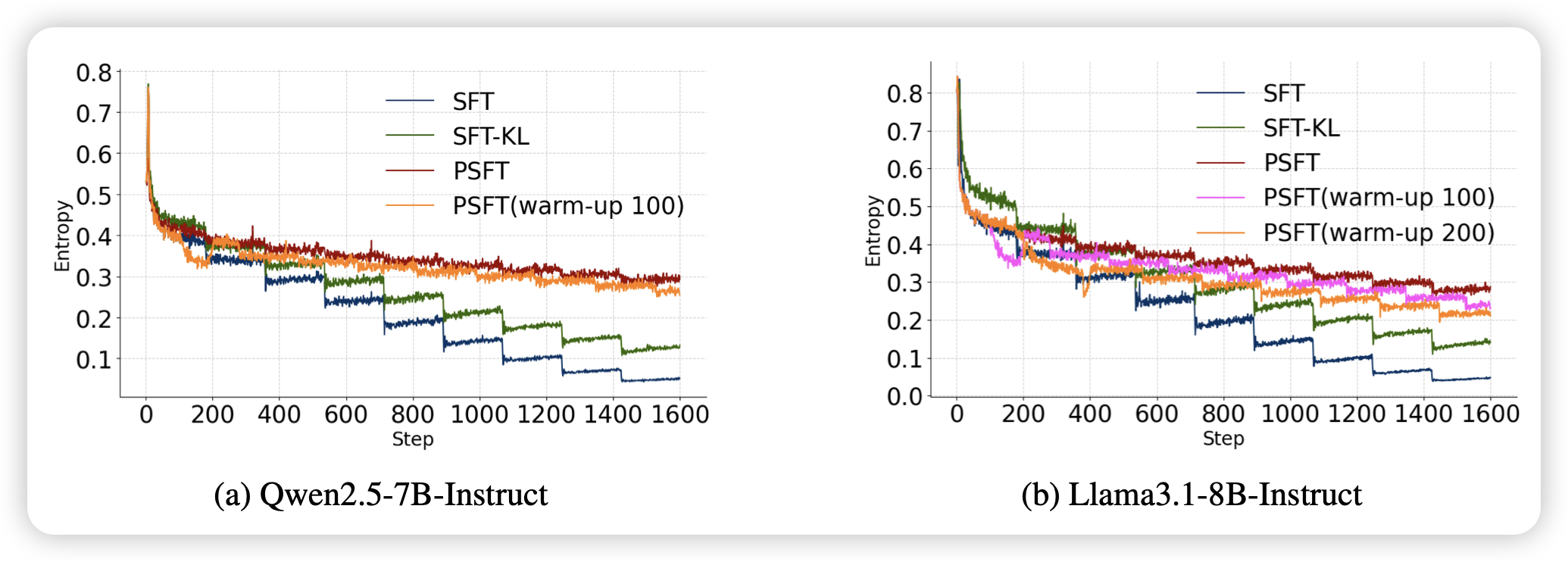

Proximal Supervised Fine-Tuning

很有意思的工作,起名就很有pengfei老师的风格。前几天qwen出了一个在rl中掺入sft的工作,今天这篇是更近一步。直接把sft数据当成一种“比较offpolicy”的数据,然后一样地做重要性采样。这样可以在sft时候每隔几个mini-batch做个old_pi sync。作者发现这样的一个改进,竟然提高了sft的泛化性

我隐约记得我在几年前见过类似的工作……当时可能是ppo出来比较火

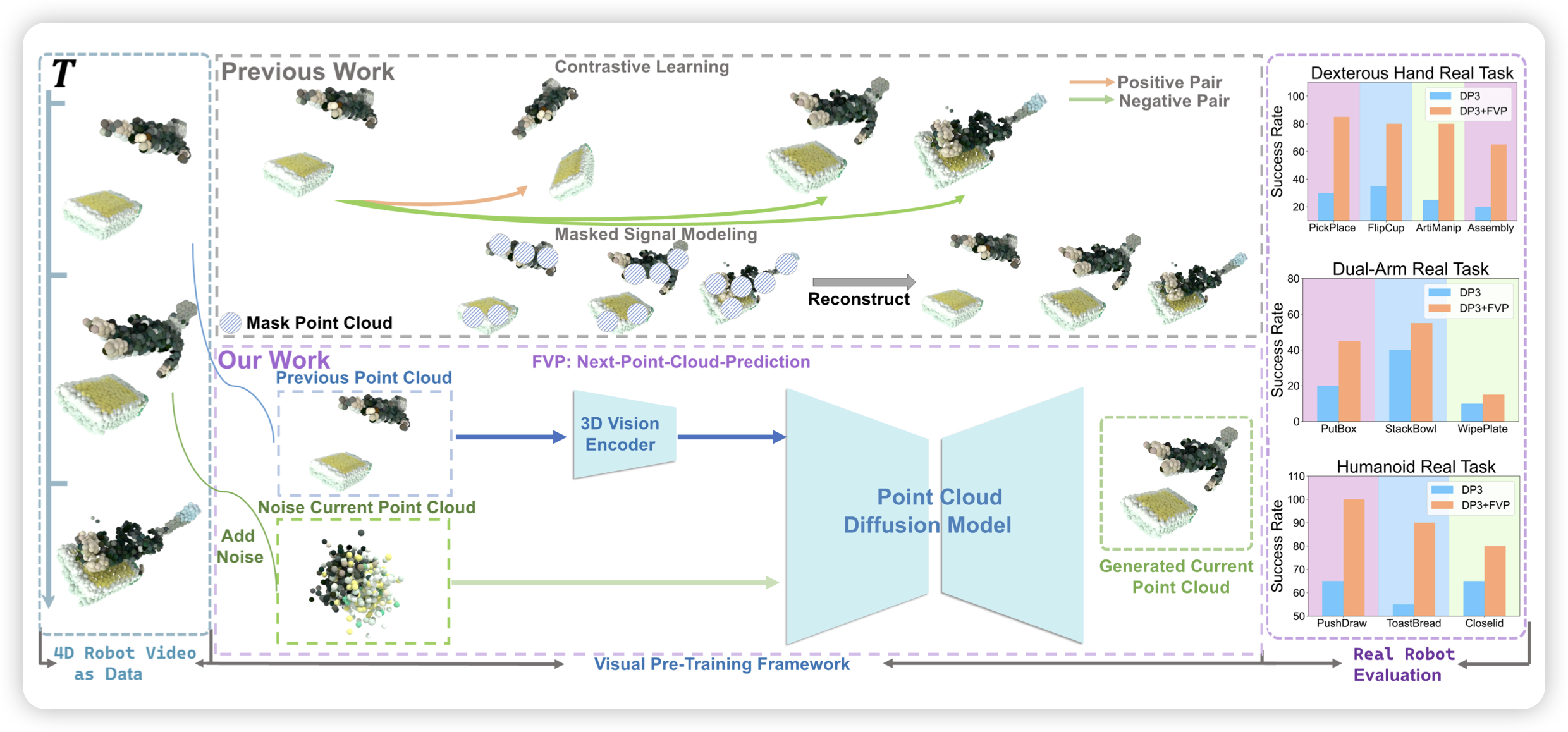

4D Visual Pre-training for Robot Learning

许老师的工作,作者提了一个next-point-cloud prediction任务,称为4d预训练。然后由此利用起已有的cloud-point数据

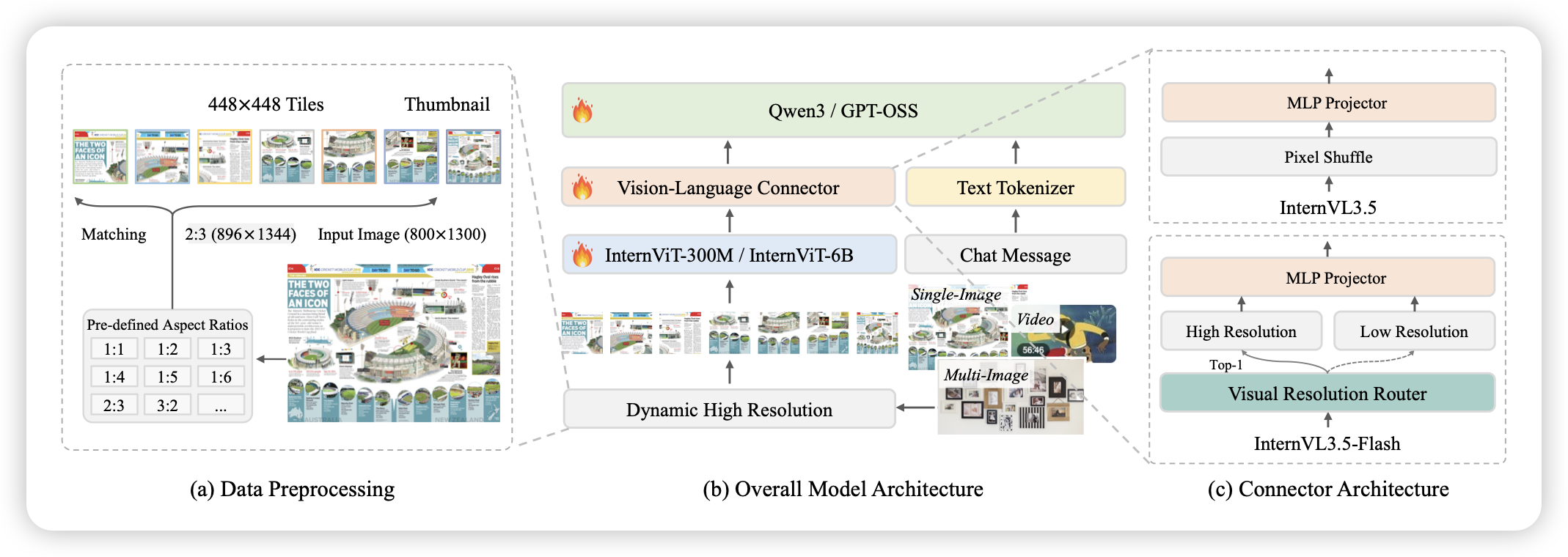

InternVL3.5: Advancing Open-Source Multimodal Models in Versatility, Reasoning, and Efficiency

intern-vl系列的最新工作,一口气开源了一堆size。230B-A28B的超大vlm,vit都有6B参数,好像第一次见到这么大的vit。各个benchmark都效果很好

这才是solid